Imposible de entender no implica imposible de utilizar

Richard Feynman, premio Nobel de Física en 1965, sin duda una de las mentes más deslumbrantes en el campo científico y dueño de una personalidad peculiar, escribió en uno de sus libros que podría decir con seguridad que nadie entiende la mecánica cuántica, y sin duda tenía razón.

Los fenómenos de la mecánica cuántica son inadmisibles y contraintuitivos para nuestro sentido común. Extrapolar ideas y tratar de encajar conceptos como la dualidad onda-partícula o la superposición de estados en los fenómenos que observamos en el mundo macroscópico y cotidiano es imposible e improductivo. Sencillamente nuestro sentido común no está preparado para asimilar la naturaleza cuántica de la materia a escalas microscópicas.

Sin embargo y afortunadamente, la mecánica cuántica cobra un sentido casi mágico y sorprendente en el lenguaje de las matemáticas. En cierto modo todo cobra sentido, y aunque su interpretación sea un tema complejo, incluso polémico, sus resultados son absolutamente predecibles, y por tanto asombrosamente prácticos.

La piedra filosofal del mundo moderno, los semiconductores, pudieron ser desarrollados gracias a los conceptos surgidos en la mecánica cuántica. Las bandas de energía y la naturaleza estadística de las partículas juegan un papel fundamental en el diseño y construcción de dispositivos como diodos, transistores y circuitos integrados, elementos fundamentales para todos los aparatos y equipos electrónicos sobre los cuales la humanidad ha construido las bases del mundo moderno.

Por tanto, aun si no entendemos la mecánica cuántica, y sus principios y leyes son totalmente inverosímiles para nuestro sentido común, el mundo tal como lo conocemos en la actualidad no sería posible sin su estudio y los constantes intentos por entenderla e interpretarla.

Carl Sagan, en respuesta a las críticas que afirmaban que la mecánica cuántica no era menos misteriosa que el shamanismo o las creencias teológicas del new age, dijo que aun si no podemos entenderla, la mecánica cuántica sencillamente funciona.

Un salto cuántico para escapar al colapso de la ley de Moore

En 1965 Gordon Moore, quien entonces trabajaba para Farichild Semiconductors, recibió una pregunta de la revista Electronics respecto al futuro de la industria de los componentes semiconductores. Él predijo que cada año la complejidad de los componentes se incrementaría en un factor aproximado de 2, y que no había razón para no pensar que eso podría continuar por los próximos 10 años.

Esa predicción se cumplió de forma casi inequívoca desde ese año hasta 1980, desde cuando el incremento en un factor de 2 se ha venido dando aproximadamente cada dos años. En 1971 un microprocesador tenía alrededor de 2300 transistores, para 2016 esta cantidad se ha incrementado a 10 billones. La miniaturización en el mismo rango de tiempo ha ido desde los 10 micrómetros hasta los 10 nanómetros.

A esta escala se está llegando al límite de la miniaturización y por tanto al final de la ley de Moore. Tal límite no es impuesto tanto por la capacidad técnica como por los principios que rigen la mecánica cuántica, los que sin embargo abren el camino para una nueva tecnología cuya frontera apenas estamos bordeando.

El gato de Schrödinger tiene la clave

A pesar de que la mecánica cuántica tiene una formulación matemática clara, coherente y precisa, la interpretación de sus fenómenos en la realidad cotidiana es un tema complejo y que más de una vez ha levantado polémica. El problema de la interpretación es que su naturaleza es tan íntima que compromete nuestra percepción de la misma realidad.

La interpretación tradicional de la mecánica cuántica, y sin duda la más difundida y tal vez aceptada, es la Interpretación de Copenhague, formulada alrededor de 1927 por Niels Bohr y Werner Hesienberg.

La interpretación de Copenhague se basa en la idea de que los sistemas a nivel cuántico no tienen un valor definido hasta el instante en que son medidos. Por tanto la mecánica cuántica únicamente puede predecir la probabilidad de un resultado. Esto implica que antes de realizar una medición un sistema contiene todos los posibles estados, cada uno de los cuales tiene una probabilidad calculable de suceder. Es solamente después de la medición que surge un estado específico a través de lo que se conoce como el colapso de la función de onda. Antes de la medición, y por tanto previo al colapso, un sistema se encuentra en una superposición de estados cuánticos.

En 1935 Erwin Schrödinger propuso un experimento mental con el cual la superposición de estados pudiese ser llevada al mundo macroscópico. Imaginó una caja totalmente aislada en la que se encontraría un gato cuya vida dependería del estado cuántico de un átomo radioactivo. Así, antes de abrir la caja el átomo se encontraría en dos posible estados, habría decaído o no, lo que implicaría que el gato estaría en dos posibles estados simultáneos vivo y muerto! De alguna manera Schrödinger trataba de demostrar lo absurdo de la superposición cuántica. Sin embargo, en lugar de esto estableció una idea que se utiliza como una paradoja a través de la cual se evalúan otras interpretaciones de la mecánica cuántica.

El gato de Schrödinger es la piedra angular de la computación cuántica, pues su capacidad de estar simultáneamente en estados vivo y muerto es análoga a un bit en estados 1 y 0.

El poder de los qbits

En 1981 Richard Feynman en una charla en el MIT dijo que la evolución de un sistema cuántico en principio no podría ser simulada por un computador clásico, así que propuso el modelo básico de un computador cuántico que podría realizar tal tarea. Luego, en 1985 David Deutsch de la Universidad de Oxford propuso el primer modelo de un computador cuántico universal, equivalente a lo que fue la propuesta de la máquina de Turing para los computadores actuales.

A diferencia de un computador convencional que utiliza bits, un computador cuántico utiliza qbits, los que análogamente al gato de Schrödinger, pueden estar en dos estados simultáneamente, en 1 y en 0. Esto significa que un solo qbit representa al mismo tiempo dos estados, por tanto 2 qbits representarían 4 estados, 3 qbits 8 estados, y en general N qbits 2^N estados simultáneos.

Esta particularidad de los qbits tiene implicaciones notables, pues la búsqueda y el procesamiento de los registros no se hace uno a uno, sino 2^N registros a la vez, en un solo paso. Así, un computador cuántico con 8 bits sería capaz de procesar simultáneamente 256 registros en un solo paso. En un computador con 300 qbits se tendría tantos estados posibles como átomos en el universo visible! Tener la capacidad de procesar tal cantidad de información resulta imposible para un computador convencional, pero para un computador cuántico sería una tarea de un solo paso.

Tal vez si pensamos en un computador cuántico como una herramienta para tareas como navegar por la Internet, ver nuestras fotografías, ver una película o revisar nuestro correo no estaremos ganando nada interesante.

Por otro lado, imaginemos un computador con estas características para realizar tareas de minería de datos de grandes volúmenes de información, para obtener la predicción del clima a nivel mundial utilizando cada variable disponible en tiempo real, para realizar el análisis de los genotipos de organismos biológicos existentes o simulados, para simular el comportamiento de complejas estructuras de ingeniería bajo cualquier condición, para analizar los masivos volúmenes de datos provenientes de un acelerador de partículas, para analizar hasta el más mínimo desplazamiento de las placas tectónicas en todo el mundo, para analizar la estructura del universo, para entender la dinámica del cerebro humano, para el desarrollo e implementación de sistemas de Inteligencia Artificial, etc. Es entonces cuando se entiende que esta tecnología no es un simple avance para las tecnologías de la información, sino que se trata de un verdadero salto cuántico para la humanidad.

Cuestión de coherencia

El mayor desafío técnico que enfrenta el desarrollo de los computadores cuánticos es mantener los qbits totalmente aislados, y evitar así que su interacción con el entorno interfiera con su estado y por tanto con la información que contengan.

Cuando un sistema cuántico interactúa se produce un "entrelazamiento" con su entorno lo que provoca que la información sea transferida. En este sentido, la información se pierde, pues se dispersa en el entorno a través del mecanismo de entrelazamiento, y al encontrarse dispersa no se puede recuperar, o al menos no es un proceso simple.

La interacción de un sistema con su entorno, lo que se conoce como decoherencia, provoca por tanto que los qbits pierdan información, la que al dispersarse por el mecanismo de entrelazamiento cuántico no puede ser recuperada, o al menos ya no es utilizable.

La decoherencia es necesaria solamente en el momento en que la información va a ser leída a través del proceso de medición, pues en nuestro entorno macroscópico necesitamos información concreta. La información superpuesta o "mezclada" no puede ser directamente utilizada.

Un aspecto importante de la información contenida en sistemas cuánticos es que una vez leída es destruida, pues la medición provoca el colapso de la función de onda y por tanto la superposición de estados de los qbits queda reducida a un único estado.

El hecho de que la información de un sistema cuántico sea destruida en el instante en que es medida, o leída para el caso, es la piedra angular de nuevos sistemas de encriptación cuántica, pues este proceso ocasiona que los datos que sean "secuestrados" por un intermediario que tenga el objetivo de leerlos de manera oculta, destruya la información original lo que puede ser detectado por el receptor.

Del Y2K al Y2Q

Aunque en la actualidad existen empresas como Swiss Quantum que fabrican equipos de encriptación cuántica a nivel comercial, o D-Wave que utiliza principios cuánticos como el quantum tunnelling para resolver problemas complejos, la computación cuántica está aun en una etapa muy temprana, y podría llegar a ser una realidad concreta alrededor de 2030 según algunos expertos.

La llegada de los computadores cuánticos sin duda marcará una revolución en el desarrollo de las tecnologías de la información, y aunque abre una ventana de posibilidades inimaginables su llegada también puede significar un enorme desafío para sociedades que se hayan mantenido al margen de sus avances, incrementando de forma considerable la brecha tecnológica entre naciones desarrolladas y naciones en vías de desarrollo.

Quizás el efecto más dramático y el primero en aparecer con el surgimiento de la computación cuántica será la anulación de los mecanismos de seguridad en los sistemas de información. El problema radica en que los sistemas actuales confían su seguridad a algoritmos que se basan en la dificultad matemática que implica la factorización de grandes números primos.

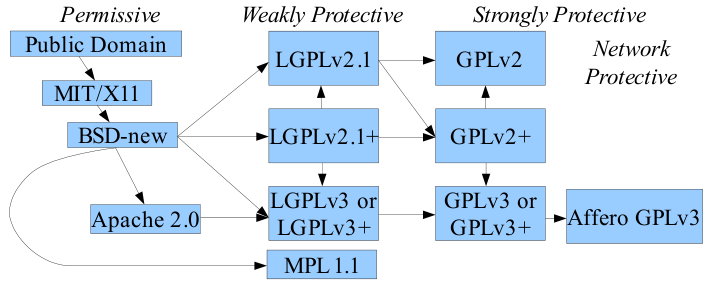

Así por ejemplo, todas las páginas seguras utilizadas por instituciones de gobierno, instituciones bancarias, servicios de correo, los monederos electrónicos de bitcoins, etc., se basan en la estructura PKI (Public Key Infrestrcture) misma que utiliza un sistema de claves asimétricas, es decir una clave para encriptar la información y otra clave para desencriptarla. Una de las claves es pública y la otra se mantiene privada, lo que permite que la clave privada no deba ser difundida y por tanto se mantenga segura.

Así por ejemplo, todas las páginas seguras utilizadas por instituciones de gobierno, instituciones bancarias, servicios de correo, los monederos electrónicos de bitcoins, etc., se basan en la estructura PKI (Public Key Infrestrcture) misma que utiliza un sistema de claves asimétricas, es decir una clave para encriptar la información y otra clave para desencriptarla. Una de las claves es pública y la otra se mantiene privada, lo que permite que la clave privada no deba ser difundida y por tanto se mantenga segura.

Sin embargo, en 1994 el matemático Peter Shore formuló un algoritmo que podría ser utilizado en un computador cuántico para romper los esquemas de criptografía de claves asimétricas como el RSA, que basa su seguridad en la dificultad computacional que supondría obtener los factores primos de la clave privada. Esto implica el fin de la seguridad en la transferencia de información tal como la conocemos actualmente. Por tanto es necesario que se desarrollen nuevo sistemas de criptografía cuya aleatoriedad no dependa de la complejidad matemática de un problema de números primos, sino de conceptos más profundos como el principio de incertidumbre de Heisenberg, que postula que la imposibilidad de realizar medidas exactas no se debe a la dificultad técnica de la medición sino a la naturaleza inherente al comportamiento cuántico de la materia a escala microscópica.

El enorme poder de procesamiento de los computadores cuánticos ofrece un gran impulso a tecnologías como minería de datos, inteligencia artificial y Big Data en las que el principal desafío es el manejo de grandes volúmenes de datos a gran velocidad. El salto cuántico que se dará en este punto hará posible la ejecución de procesos mucho más complejos y avanzados con los que el análisis de perfiles de usuarios y la búsqueda de patrones hará posible identificar de forma unívoca a cualquier usuario de la red, lo que supondrá un nuevo desafío la confidencialidad y la privacidad de las personas en un entorno en el que la red no solamente será más inteligente, sino que evolucionará con mayor rapidez.

El establecimiento de nuevas estrategias y políticas inteligentes es indispensable para asegurar que la computación cuántica se convierta en una oportunidad valiosa, y no en un desafío insalvable para las sociedades menos desarrolladas.

Quizás el Y2K (years to 2000) no fue un evento tan dramático como se esperaba, y aun así es considerable el esfuerzo y la inversión que realizaron muchos gobiernos y empresas para atenuar sus efectos. Sin embargo el Y2Q (years to quantum) puede ser un evento mucho más dramático y con mayores consecuencias, muchas de las cuales aun no se han entendido en toda su magnitud.

El enorme poder de procesamiento de los computadores cuánticos ofrece un gran impulso a tecnologías como minería de datos, inteligencia artificial y Big Data en las que el principal desafío es el manejo de grandes volúmenes de datos a gran velocidad. El salto cuántico que se dará en este punto hará posible la ejecución de procesos mucho más complejos y avanzados con los que el análisis de perfiles de usuarios y la búsqueda de patrones hará posible identificar de forma unívoca a cualquier usuario de la red, lo que supondrá un nuevo desafío la confidencialidad y la privacidad de las personas en un entorno en el que la red no solamente será más inteligente, sino que evolucionará con mayor rapidez.

El establecimiento de nuevas estrategias y políticas inteligentes es indispensable para asegurar que la computación cuántica se convierta en una oportunidad valiosa, y no en un desafío insalvable para las sociedades menos desarrolladas.

Quizás el Y2K (years to 2000) no fue un evento tan dramático como se esperaba, y aun así es considerable el esfuerzo y la inversión que realizaron muchos gobiernos y empresas para atenuar sus efectos. Sin embargo el Y2Q (years to quantum) puede ser un evento mucho más dramático y con mayores consecuencias, muchas de las cuales aun no se han entendido en toda su magnitud.